Clicca sull'immagine seguente per andare direttamente ai video di Ninobot.

VIDEO

|

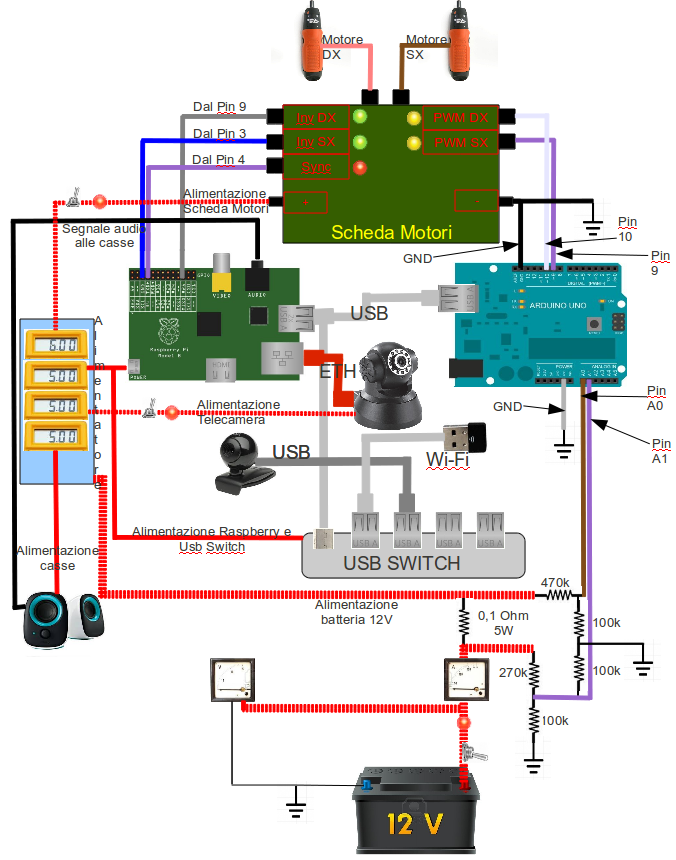

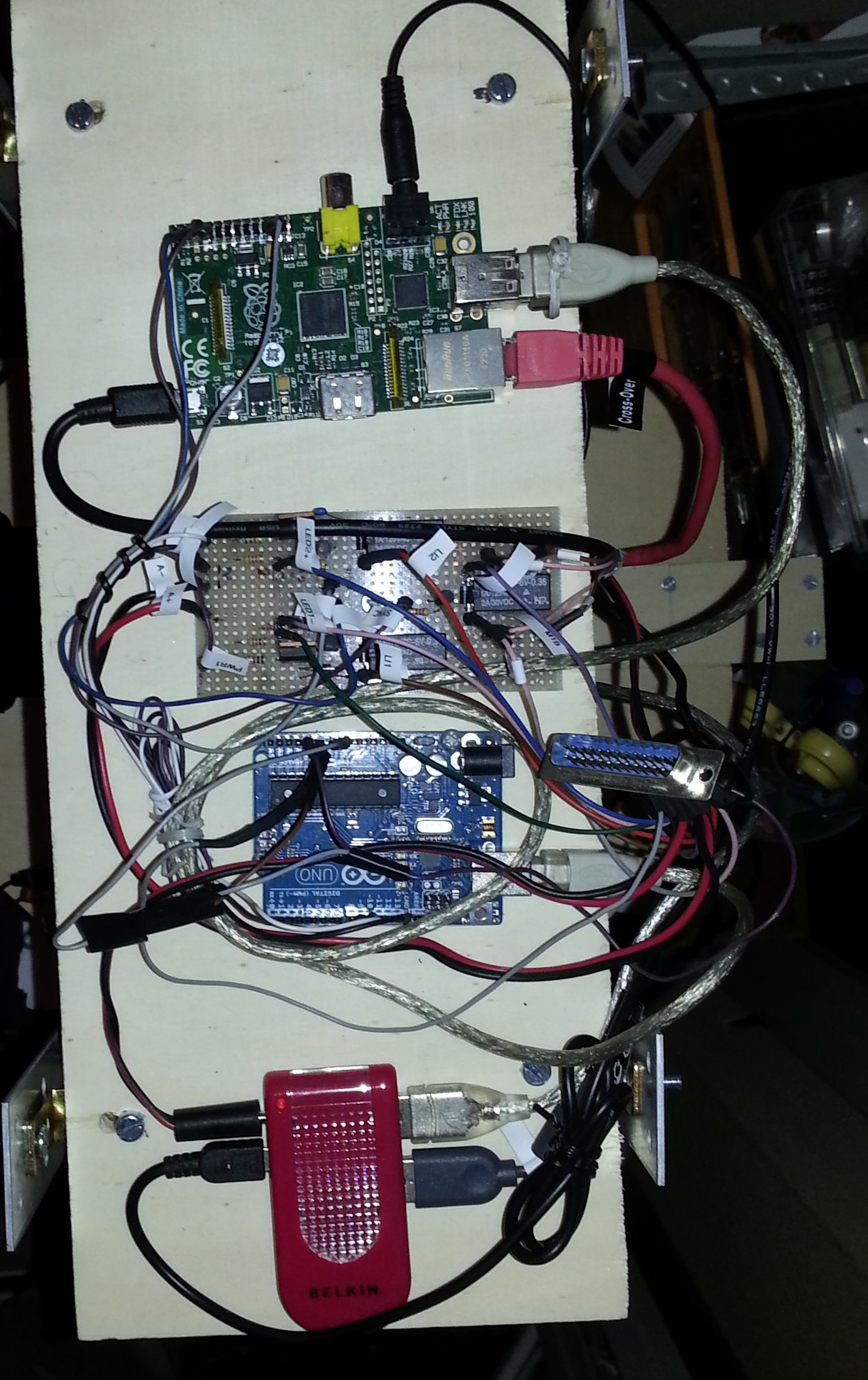

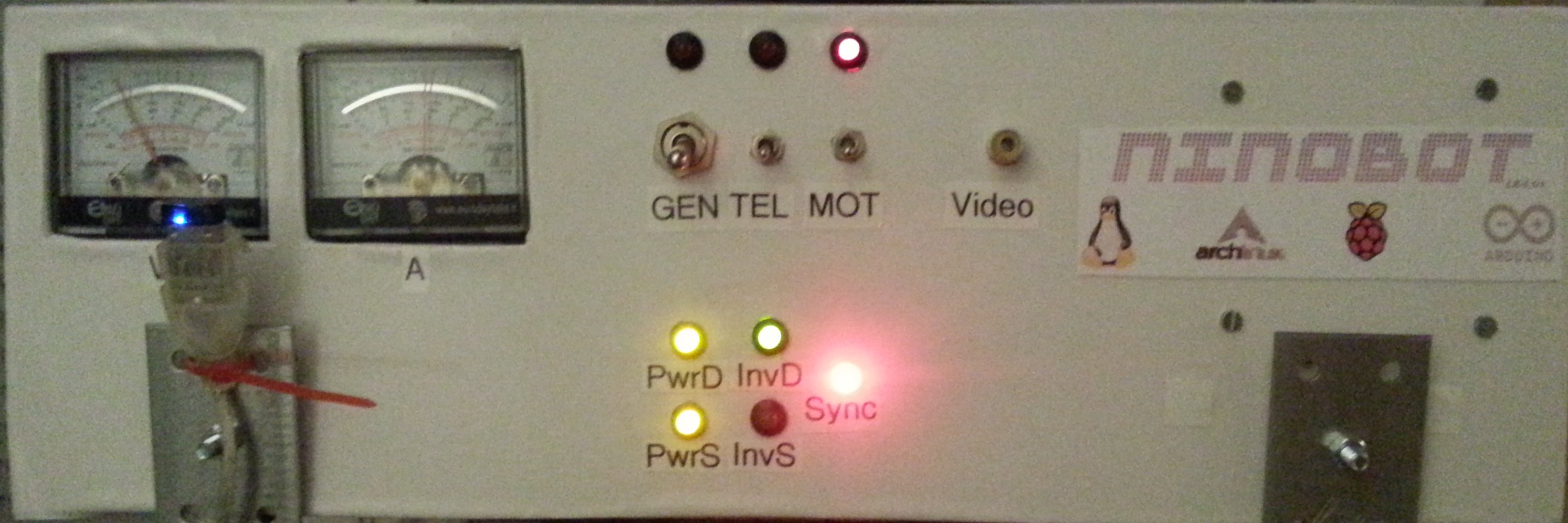

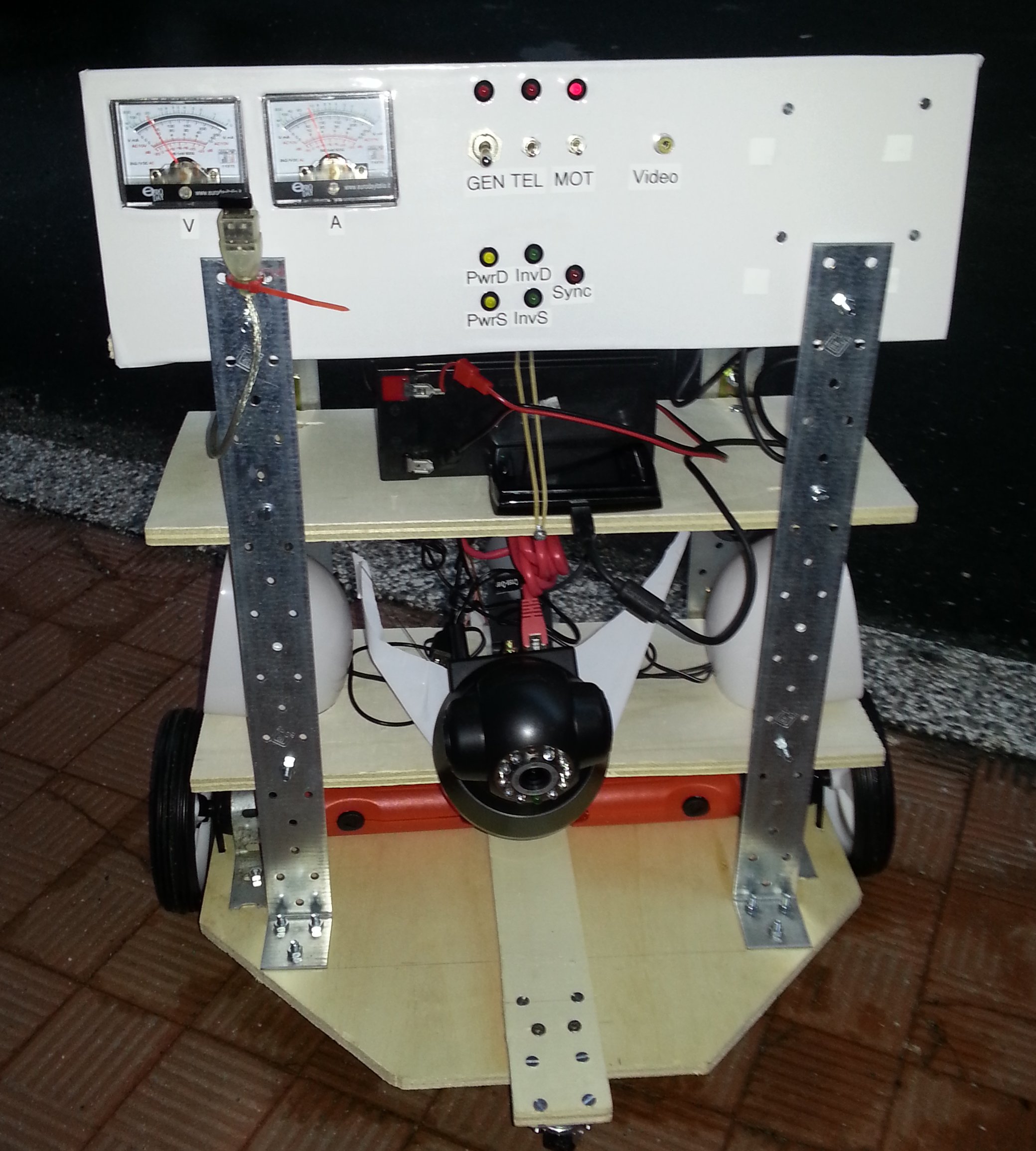

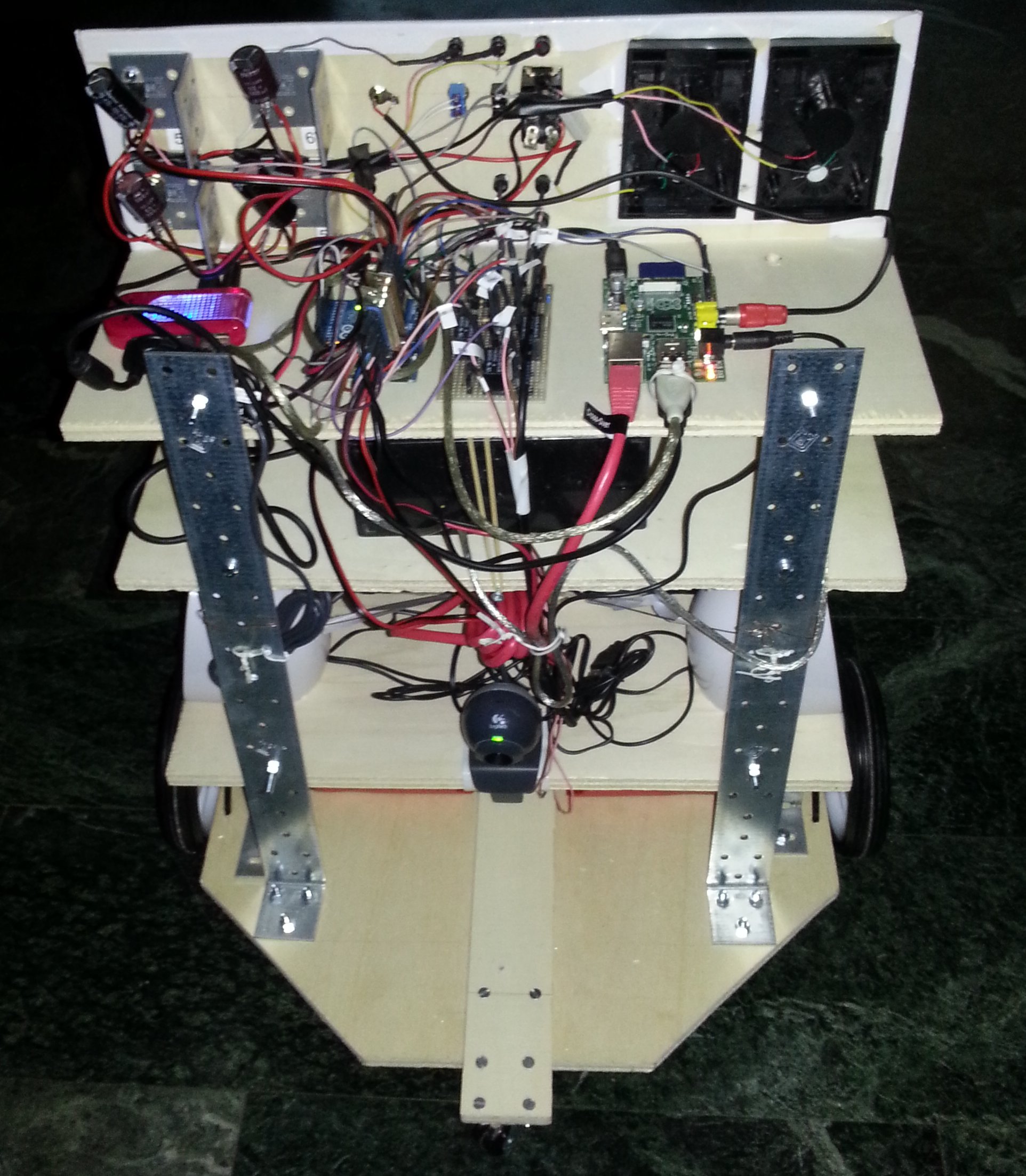

Carissimi amici di Ninobot! Ho il piacere di presentarvi la nuova versione del robottino. Lungi dall'essere un'esposizione completa (la scrivero' non appena mi sara' possibile), le tre foto che vedete in questa pagina vogliono solo mostrare il nuovo aspetto di Ninobot e qualche particolarita'. Questa e' la parte anteriore. Dall'alto verso il basso si possono vedere:

|

|

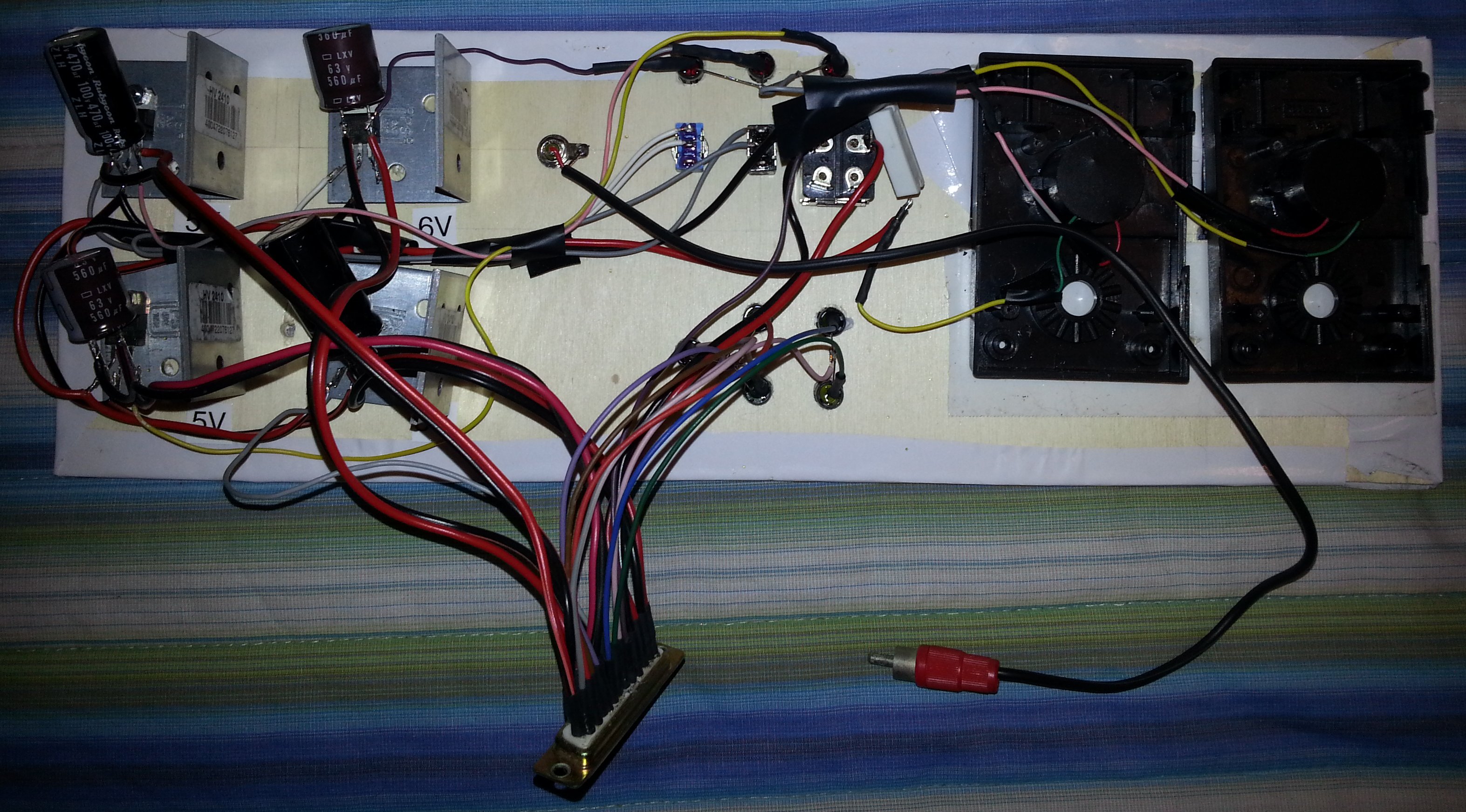

In questa seconda foto e' possibile osservare la parte laterale di Ninobot.

Dall'alto verso il basso abbiamo:

|

|

Nella parte posteriore e' visibile uno degli elementi principali di Ninbot. Andando come al solito con ordine, abbiamo:

La trattazione che segue non e' stata modificata e riguarda ancora la versione prototipale di Ninobot. Nonostante non sia aggiornata, illustra tuttavia tutte le principali funzionalita' del sistema e come e' stato realizzato. |

Introduzione

Correva l'anno 1980 ed un ragazzino di un piccolo paese della Sicilia vedeva, per la prima volta nella sua vita, il modellino radiocomandato di un'automobile.

Fu un amore a prima vista. Quel ragazzino, da sempre appassionato di elettronica e tecnologia, quel giorno decise che avrebbe costruito un suo modellino radiocomandato, ma non un modellino qualsiasi. Doveva essere qualcosa di simile ad un robot e si sarebbe dovuto pilotare comodamente da casa, senza vederlo fisicamente, anche a distanza di chilometri. Poco meno che un sogno per un quattordicenne, con tanta passione ma senza conoscenze, che amava mettere il naso nei televisori e nelle radio a valvole per cercare invano di carpire qualche segreto.

Quel ragazzino ero io e solo ora a distanza di anni mi rendo conto di quanto quel sogno, assurdo ed impossibile, sia stato per me la chiave di tante delle decisioni che ho preso nella vita, dalla scelta di iscrivermi alla Scuola Radio Elettra di Torino a quella di prendere la laurea in Ingegneria Elettronica.

Con il passare del tempo il robottino ha cambiato forma, si è evoluto sia funzionalmente che strutturalmente e tante delle caratteristiche che avrebbe dovuto avere hanno trovato una chiara soluzione tecnica.

Andiamo con ordine però. La storia è appena iniziata.

Il target minimale

Quello che volevo realizzare, almeno inizialmente, è un oggetto conosciuto con il nome di UGV (Unmanned Ground Vehicle – Veicolo di terra senza pilota). Ho aggiunto anche l'acronimo LR alla definizione (Long Range) in quanto l'idea era quella di poterlo pilotare, almeno in teoria, “da qualsiasi posto, in ogni posto”. Ho dovuto accettare qualche compromesso però. Per adesso, per semplicità, posso pilotarlo solo da casa (le questioni tecniche relative le descriverò in seguito) ma, virtualmente, posso fargli coprire un'area pari all'intero territorio italiano. In effetti sarebbe meglio dire che la copertura di Ninobot è pari alla copertura della scheda SIM che utilizzo nel modem 3G. Dove arriva il segnale di quell'operatore telefonico può arrivare anche Ninobot.

Gli UGV, attualmente, sono utilizzati principalmente per scopi militari e sono controllati attraverso un satellite per telecomunicazioni. Gli UAV (Unmanned Aerial Vehicle), anche conosciuti come Droni, sono anch'essi telecomandati ma, come recita lo stesso acronimo, non “strisciano” sulla nuda terra: volano! Vedrò, in un prossimo futuro, di apportare tale miglioramento a Ninobot.

Requisiti di un UGV

Ma cosa deve avere a bordo un UGV per funzionare correttamente? Compiliamo la lista della spesa.

-

un motore (ovviamente) per farlo muovere,

-

un timone o qualcosa che permetta di modificare la sua direzione,

-

un sistema di controllo che deve essere tanto più sofisticato quanto più lo si vuole “intelligente”,

-

una telecamera, meglio se due,

-

un microfono per trasmettere i suoni ambientali,

-

un sistema di alimentazione (quindi una buona batteria se completamente elettrico).

Per quanto riguarda i sistemi di controllo, oggi non c'è che l'imbarazzo della scelta oltre che la “noia” di doverli programmare. Sto parlando di veri e propri microcomputer, con tanto di processore, uscita video, uscita audio, USB, scheda ethernet, sui quali si può far girare comodamente un sistema operativo completo e potente come Linux, in una delle sue varie distribuzioni.

Ho provato due di queste soluzioni.

La prima, in ordine temporale, è stata la BeagleBoard. Si tratta di una scheda basta su un processore ARM Cortex A8 con 512 MB di RAM. Ci gira senza problemi Ubuntu e, configurata correttamente, pare sia in grado di riprodurre un film in Full HD. Ho da poco scoperto che ne è uscita un'altra versione, la BeagleBone, dalle dimensioni e dai costi più contenuti.

La seconda è la Raspberry PI. Si basa anch'essa su un processore ARM a 700MHz e nell'ultimissima versione sono disponibili 512 MB di RAM contro i 256 della versione precedente. Il suo punto di forza è il costo: appena 30 euro che diventano poi 38 con le spese di spedizione. Al di là del fatto che ho dovuto aspettare 5 mesi per averla (l'ho ordinata a Giugno del 2012 e mi è arrivata a Novembre) e che ho riscontrato un piccolo problema HW sull'ormai famoso fusibile F3 (http://elinux.org/R-Pi_Troubleshooting#Troubleshooting_power_problems) posso dire di essere molto contento dell'acquisto. L'ho provata con Arch Linux, una versione molto robusta e completa del Sistema Operativo del pinguino, ed ho capito che sarebbe diventata il pezzo principale del mio Ninobot.

La scelta della telecamera è stata molto più complicata. Anzi, a dire il vero, è stata bloccante. Per mesi ho cercato una soluzione che andasse bene, ma sempre con risultati insoddisfacenti. Di telecamere il mercato è pieno, specie se parliamo di telecamere USB. Adesso la scelta si è ampliata a quelle Ethernet/Wi-Fi con costi davvero contenuti. Appena qualche anno fa, comprare delle “Ipcam” era decisamente proibitivo. Per ragioni tecniche, però, erano anche le uniche che facevano al caso mio. Il problema è la cosiddetta latenza. Per bene che vada, con una telecamera USB non si riesce ad avere l'immagine prima di 1,5/2 secondi; un'era geologica per un'applicazione in tempo reale. A questo effetto “hardware” indesiderato si aggiunge anche il buffering “software”. Tutti i server per video streaming che ho provato, prima di inviare l'immagine, la bufferizzano creando ulteriore ritardo. La soluzione doveva per forza essere una Ipcam che ha dei tempi di risposta estremamente rapidi ed un suo software proprietario per l'accesso ai dati. Il problema della latenza, comunque, è stato un problema ricorrente in questo progetto e, spesso, per evitare il dilatarsi dei tempi, specie sulle connessioni 3G, ho dovuto rivedere gran parte del software.

Altra cosa delicata, è stato reperire il motore. I motori, dovrei

dire, perché Ninobot ne utilizza due. La direzione, infatti, viene

determinata modulando opportunamente la potenza che viene fornita ad

entrambi: uguale potenza per farlo andare diritto, potenza al solo

destro per farlo andare a sinistra e viceversa. In generale se Pd>Ps

(Pd=potenza motore di destra, Ps=potenza al motore di sinistra),

Ninobot va a sinistra, se Ps>Pd Ninobot va a destra. E' lo stesso

principio di tutti i mezzi cingolati. La soluzione dei due motori, se

le ruote sono posizionate all'esatta metà del veicolo, consente di

azzerare l'angolo di curvatura. In altre parole, fornendo la stessa

potenza ai motori ma invertendo la rotazione di uno dei due, il robot

inizia a girare su se stesso, intorno al suo centro di massa,

rendendo semplice il cambio di direzione anche in spazi ristretti.

Il nuovo inizio

Ero all'edizione invernale del Marc, la fiera dell'elettronica di Genova, poco prima del Natale 2012. L'ho vista lì. Era la telecamera Ethernet con “tilt e pan” (brandeggiabile) che avevo sempre sognato ad un prezzo incredibile: solo 45 euro. Non ero sicuro dei tempi di risposta del software a bordo, ma mi sono detto: “forse non sarà perfetta però quando mi ricapita un'occasione simile?”

I test mi hanno dato ragione. L'immagine veniva trasferita in un tempo abbastanza breve da poter essere considerato istantaneo, almeno per le mie esigenze. Certo ho dovuto studiare parecchio per poterla integrare con la Raspberry PI che avevo ricevuto appena il mese prima.

Mancavano solo i motori. Nel negozio di modellismo dove ero andato, esposto il mio problema, mi avevano detto che ci volevano anche 400 euro per un motore con le caratteristiche da me richieste ed i relativi riduttori. Decisamente troppi per un progetto squisitamente casalingo. Sono andato allora da Brico e mi sono guardato intorno sicuro che nel regno del “fai da te” avrei trovato un'ispirazione.

E' inimmaginabile la quantità di motori elettrici e non che si trova in un negozio del genere, peccato che sono sempre integrati in qualcos'altro. Ci sono i motori a scoppio dei tagliaerba e delle seghe a nastro, i motori elettrici dei trapani, dei seghetti alternativi, delle smerigliatrici. Tutti troppo potenti per le mie necessità e quelli elettrici vanno alimentati con a 220 Volt, tensione decisamente elevata per Ninobot. A parte questo non avrebbe avuto molto senso spendere 50x2=100 euro, come minimo, per comprare due attrezzi da cui estrarre il motore. Quando l'impresa sembrava ormai disperata, l'occhio mi è caduto sulla soluzione. In un semplice strumento avevo trovato tutto quello che mi serviva: il prezzo contenuto, la tensione bassa, il riduttore di giri e quindi la necessaria potenza. Sembrava incredibile, ma i miei desideri avevano un nome preciso: l'avvitatore/svitatore elettrico!

Ne ho comprati due della Black & Decker per 9,90

euro l'uno e,

anche se li ho dovuti aprire e sezionare rendendoli di fatto

inutilizzabili per lo scopo per il quale erano stati costruiti, la

spesa era abbastanza irrisoria per poter affrontare il rischio di

rimanere con nulla in mano.

L'operazione è stata “chirurgica” ma è riuscita. Sono riuscito a recuperare non solo i motori ma anche i riduttori di giri, i cosiddetti “riduttori planetari” il cui nome altisonante è dovuto al loro particolare funzionamento e forma.

Un esempio di riduttore planetario è rappresentato nell'immagine a fianco. N.B. Il riduttore del Black & Decker non è così grande :-) .

Componenti utilizzati

A questo punto, non me ne vogliano i meno esperti, entriamo nel vivo della parte tecnica. Inizio dall'hardware elencando e descrivendo tutti i componenti fisici che sono stati utilizzati per Ninobot. Proseguirò poi con il software, quindi listati dei programmi e scelte tecnologiche.

Qualcuno sarà interessato a questa parte, altri la troveranno estremamente noiosa. Io, da parte mia, cercherò sempre di spiegare tutto nel modo più semplice possibile in modo da rendere gradevole la lettura anche a coloro che non amano entrare nel merito delle questioni tecniche.

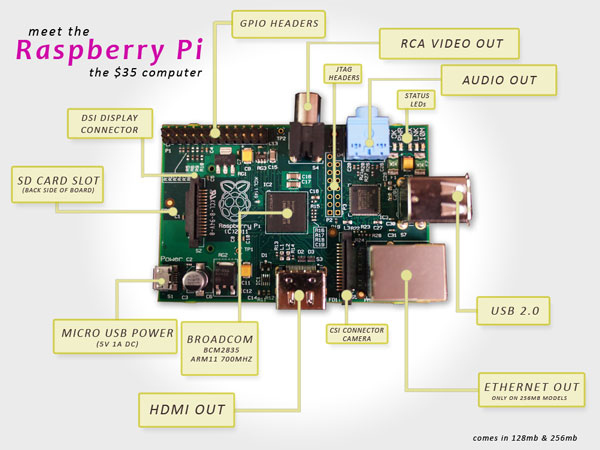

E' il componente hardware principale di Ninobot. Ma

esattamente di

cosa si tratta? Tutti ormai utilizziamo il computer e non credo che

ci sia bisogno di spiegare a nessuno cos'è. Ecco la Raspberry PI è

un computer ma è talmente piccolo che può stare comodamente nel

palmo della vostra mano. Miracoli della miniaturizzazione. D'altra

parte i nuovi telefoni, i cosiddetti “smartphone”, cosa sono se

non dei piccoli computer? Nell'immagine a fianco potete vedere come

si presenta questa piccola meraviglia tecnologica.

D'altra

parte i nuovi telefoni, i cosiddetti “smartphone”, cosa sono se

non dei piccoli computer? Nell'immagine a fianco potete vedere come

si presenta questa piccola meraviglia tecnologica.

Iniziando dall'alto e procedendo in senso orario abbiamo:

-

GPIO (General Purpose Input Output) Headers. Sono connettori di ingresso/uscita programmabili. Le tensioni in gioco sono di massimo 3,3 volt. Sarebbe stato meglio avere i classici 5 volt ma va bene così. A cosa servono? Volete accendere una lampadina con la Raspberry? Oppure sapere la lampadina è accesa? Un po' di circuiteria di contorno e potete farlo con i GPIO.

-

RCA Video Out. Classica uscita a cui si può collegare un televisore o un monitor con ingresso video composito.

-

JTAG (Join Test Action Group) Headers. E' un standard ormai molto diffuso per effettuare il debug di schede come questa. Debug è una parola che può sgomentare i meno esperti. Tradotto dal tecnichese vuol dire che, collegando una apparecchiatura compatibile a questo morsetto, è possibile capire cosa sta succedendo dentro la scheda stessa.

-

Audio out. Ebbene sì: la Raspberry ha anche un uscita audio stereo. Peccato che non abbia anche un ingresso audio, ma a questo si può porre rimedio.

-

Status LEDs. Sono i led che indicano lo stato della scheda come in ogni computer che si rispetti (alimentazione, accesso al disco, scheda di rete ecc.)

-

USB 2.0. Due porte.

-

Ethernet Out. E' la presa di rete con i soliti due led, verde e arancione.

-

CSI (Camera Serial Interface) Connector Camera. E' uno standard sviluppato dalla MIPI Alliance per connettere telecamere compatibili. A dire il vero, non saprei proprio dove trovarne con quelle caratteristiche.

-

HDMI OUT. Avete letto bene! Con l'apposito cavetto, potete collegare la Raspberry ad un TV o un monitor di ultima generazione con risoluzione Full HD 1920x1080.

-

Broadcom BCM2835. E' il processore utilizzato da questa scheda. Si tratta di un ARM a 700MHz, non poco considerando lo spazio contenuto.

-

MICRO USB POWER. La Raspberry va alimentata a 5V con un cavo USB-MicroUSB. Non è necessario avere un alimentatore con uscita USB. Funziona anche con la corrente erogata dalla normale presa USB di un PC.

-

SD CARD SLOT. Alloggiamento per la scheda SD (quello delle più comuni macchine fotografiche digitali per intenderci) che conterrà il sistema operativo della Raspberry.

Virtualmente è possibile usare qualsiasi sistema operativo ma sul sito (http://www.raspberrypi.org/), nella sezione download, ad oggi 30/03/2013, ne vengono proposti solo quattro:

-

Raspbian “wheezy”. E' quella consigliata per “partire”. Dispone di una interfaccia grafica molto leggera e funziona piuttosto bene.

-

Soft-float Debian “wheezy”. Come la precedente ma ottimizzata per l'utilizzo di software come Oracle JVM.

-

Arch Linux ARM. Si basa sulla distribuzione standard di Arch Linux e non dispone immediatamente di una interfaccia grafica che, se ritenuta opportuna, va scaricata dopo l'installazione.

-

Risc OS. Si basa su un sistema operativo sviluppato a Cambridge. Questa versione è rilasciata gratuitamente agli utilizzatori della Raspberry PI.

Non avendo la necessità delle particolari ottimizzazioni offerte dalla Soft-float Debian e non essendo ancora disponibile la Risc OS quando ho iniziato il progetto, la scelta si limitava alla “wheezy” o alla Arch Linux. Le ho provate entrambe ma sulla “wheezy” non riuscivo a far girare alcune periferiche che, per contro, giravano benissimo sulla Arch Linux. Forse spendendoci più tempo avrei potuto risolvere il problema ma la scelta della Arch Linux, più compatta e più professionale, mi è sembrata la migliore delle due e l'ho adottata.

Non senza qualche remora però. La “wheezy” si basa sulla Debian che è un sistema operativo che conosco bene in quanto è alla base di Ubuntu, la versione di Linux più utilizzata probabilmente. Di Arch Linux, invece, non ne avevo mai sentito parlare. Per l'installazione dei pacchetti non si usa l'ormai classico apt-get, i servizi vengono gestiti in modo diverso, file di sistema estremamente importanti non ci sono o sono sostituiti da altri a me sconosciuti. La scelta di un sistema operativo è di estrema importanza per lo sviluppo di un progetto e, per un po' di tempo, ho temuto che mi sarei dovuto fermare per qualche strana incompatibilità del software o per l'impossibilità di gestire condizioni particolari. Per fortuna non è stato così grazie anche alla varietà dei pacchetti ed alla documentazione disponibile.

Cosa ho installato? Come? Perché? Nel prossimo paragrafo vedremo in dettaglio la configurazione di questo sistema operativo anche per capire in cosa differisce da quelli più noti.

Arch Linux e configurazione S.O.

Installare il sistema operativo è una cosa molto semplice. Basta seguire le istruzioni sul sito quindi non mi dilungherò su questo argomento. Terminata questa operazione bisogna configurare il sistema.

Di seguito elencherò tutti i punti degni di nota.

Pacman.

Non è il nome del famoso gioco di parecchi anni fa, ma quello del gestore di pacchetti software (Packet Manager) che sostituisce in Arch Linux i più noti apt-get e yum. Che bisogno ci fosse di un nuovo gestore pacchetti non lo so e non me lo voglio chiedere. Il comando, comunque, è piuttosto semplice da utilizzare.

Per installare il pacchetto xyz ad esempio basta digitare:

pacman -S xyz

Per installarlo aggiornando la lista dei pacchetti disponibili sul repository:

pacman -Sy xyz

Per rimuoverlo:

pacman -R xyz

Per fare l'upgrade di tutto il sistema:

pacman -Syu

Queste istruzioni sono più che

sufficienti per iniziare. Se si volesse approfondire l'argomento,

consiglio la pagina di ArchWiki

relativa.

Rete.

Ninobot è pilotato da una interfaccia web che risiede sul server Apache della Raspberry. Sarò più dettagliato in seguito sull'argomento. Adesso volevo solo rimarcare il fatto che tale interfaccia esiste e che in qualche modo deve essere raggiungibile dall'esterno. Come? Via wireless!

Quando Ninobot viene acceso, si collega automaticamente all'hotspot Wi-Fi di casa mia e da questo momento è possibile pilotarlo da qualsiasi computer connesso alla stessa rete. E se volessi controllarlo da casa ma si trovasse dall'altra parte della città o, addirittura, in un'altra città? In questo caso, collego Ninobot ad un telefonino di ultima generazione che dispone del tethering USB (la possibilità di usare il telefonino come modem) e creo una VPN (una sorta di tubo virtuale) fra la Raspberry ed il computer da cui mi voglio connettere. E' una possibile soluzione, ma non è l'unica.

Qualunque sia la soluzione, comunque, ho bisogno di configurare la rete della scheda di controllo e per farlo devo:

-

installare il pacchetto netcfg (pacman -S netcfg);

-

installare il pacchetto wireless_tools (pacman -S wireless_tools);

-

configurare netcfg in modo che parta all'avvio della Raspberry (systemctl enable netcfg.service);

-

creare un file /etc/network.d/nomemiarete che contiene:

CONNECTION='wireless'

DESCRIPTION='A simple WEP encrypted wireless connection'

INTERFACE='YOURINTERFACE'

SECURITY='YOURSECURITY'

ESSID='YOURSID'

KEY='YOURKEY'

IP='dhcp'

# Uncomment this if your ssid is hidden

#HIDDEN=yes

## Uncomment if you are using an ad-hoc connection

#ADHOC=1

dove YOURINTERFACE sarà qualcosa del tipo wlan0, YOURSECURITY può essere “wep” o “wpa” (ci sono altri due casi ma più complicati per cui vi rimando al manuale di netcfg), YOURSID è il SID della vostra rete Wi-Fi (lo trovate sulla configurazione del router di casa), YOURKEY è la password che conoscete solo voi (anche questa si ricava dalla configurazione del router). Questa è una delle configurazioni più semplici. Se avete bisogno di qualcosa di più complicato, fate riferimento al manuale.

-

Modificare il file /etc/conf.d/netcfg dove la linea

NETWORKS=(last) diventa NETWORKS=(last nomemiarete)

Si noti che al punto 3 ho utilizzato il comando systemctl. Tale

comando non è presente su Ubuntu, almeno non di default, quindi

anche questa si può considerare una piccola differenza fra le due

versioni di Linux. Devo dire tuttavia che systemctl è davvero

comodo. Se lanciato senza parametri, fornisce l'elenco dei servizi ed

il loro stato, ma non solo.

Per disabilitare un servizio all'avvio del sistema operativo:

systemctl disable nomeservizio.service

Per attivare un servizio:

systemctl start nomeservizio.service

Per fermare un servizio:

systemctl stop nomeservizio.service

Per fare ripartire un servizio:

systemctl restart nomeservizio.service

Per ulteriori informazioni riguardo a questo interessantissimo comando, anche stavolta vi rimando al manuale.

Come ho prima accennato, Ninobot può essere configurato anche per il telecontrollo a lunga distanza. Questo si ottiene senza modifiche eccezionali utilizzando un telefono 3G con tethering. Sul tethering ci sarebbe da parlare a lungo. Vi basti sapere, tuttavia, che si tratta di una tecnica che vi consente di utilizzare il telefono come se fosse un modem collegandolo al PC. Il collegamento può essere fatto in tre modi diversi: con il Wi-Fi, con il Bluetooth oppure, ed è il metodo che ho usato per questo progetto, via USB.

Per completezza, scrivo anche che ho provato ad utilizzare diverse chiavette 3G USB ma senza alcun risultato. Purtroppo Arch Linux sembra non essere compatibile con la maggior parte delle chiavette in circolazione. Ho provato diversi modelli ma non sono riuscito a farne funzionare nemmeno una. Anche la E173 Huawei, molto diffusa, non va in modalità modem. Su alcuni forum consigliano di usare la E173s ma non vorrei acquistarla senza essere prima sicuro di poterla utilizzare.

Detto questo torniamo al tethering. Di cosa abbiamo bisogno?

Di un cellulare con tethering e di un cavetto usb.

Cosa dobbiamo fare? Di seguito spiegherò tutti i passi necessari per effettuare il collegamento. Do per scontato che:

-

la macchina da cui ci colleghiamo sia una macchina Linux, o Unix più in generale, e su di essa siano installati i seguenti programmi:

-

netcat – il coltellino svizzero delle reti;

-

pppd – il point-to-point protocol daemon;

-

il cellulare utilizzato sia Android;

-

netcat e pppd devono essere installati anche su Arch Linux, se non già presenti, utilizzando la solita procedura (pacman -S openbsd-netcat e pacman -s ppp)

Detto questo, ecco, passo passo, cosa bisogna fare.

-

Accendere il telefonino (ovviamente) ed attivare la connessione 3G (attenti al credito);

-

collegare il telefonino alla Raspberry PI utilizzando l'apposito cavetto microUSB-USB;

-

andare su impostazioni => altre impostazioni => tethering e router wi-fi => tethering USB (dovrebbe apparire il segno di spunta ad indicare che la modalità è attiva);

-

eseguire su Raspberry ifconfig usb0 up && dhcpcd usb0; si noti che:

-

quando si collega il telefonino, il sistema creerà una nuova device che però potrebbe non chiamarsi usb0; controllare sempre con il comando ifconfig per avere la lista delle periferiche di rete;

-

se usb0, o qualcosa di simile, non appare nella lista delle device di rete, potrebbe essere necessario caricare prima del collegamento il modulo opportuno con il comando che segue: modprobe usbnet.

-

Sul PC (connesso ad Internet con indirizzo IP pubblico) da cui si vuole controllare Ninobot lanciare il comando

pppd noauth pty "netcat -l -p 5600" silent 192.168.1.1:192.168.1.2 local

Si noti che:

-

pppd e netcat potrebbero essere stati installati su percorsi inaccessibili o necessitare di speciali privilegi per essere eseguiti (privilegi di root ad esempio);

-

i due indirizzi indicati sono puramente esemplificativi. Ognuno può utilizzare quelli che vuole a patto che non siano in conflitto con quelli della propria rete.

-

Anche la porta 5600 è stata scelta a titolo di esempio. Qualunque essa sia deve essere visibile da Internet, quindi non bloccata da alcun firewall.

-

Eseguire sulla Raspberry PI il comando

pppd noauth pty "netcat <ip_pubblico_pc_di_controllo> 5600" 192.168.1.2:192.168.1.1 local

L'ip pubblico del PC di controllo potrà variare da connessione a connessione in quanto molto spesso tale ip è scelto dinamicamente dal gestore telefonico.

-

A questo punto sul PC di controllo e sulla Raspberry sarà apparsa una nuova periferica di rete del tipo ppp0 o simile. Sul PC tale periferica avrà l'indirizzo 192.168.1.1 mentre sulla RPI sarà 192.168.1.2. Si è così creata una sorta di VPN (un tubo di collegamento) fra i due punti. Per connettersi al server web di Ninobot (o a qualsiasi altro servizio di rete) dal PC, sarà sufficiente utilizzare l'indirizzo 192.168.1.2 ed il gioco è fatto.

-

Per diconnettersi basterà killare il processo netcat da uno dei due lati. Sulla RPI sarà anche necessario il comando dhcpcd -x usb0 per interrompere il collegamento tethering con il cellulare.

Scusatemi ma non potevo essere meno tecnico di così.

Rete per Ipcam

La telecamera principale Ipcam può essere collegata alla rete via Ethernet o via Wireless. Io ho preferito la prima soluzione per due motivi.

-

Avendo collegato la Raspberry via Wireless, rimaneva la porta Ethernet di questa scheda libera;

-

se anche l'Ipcam fosse stata collegata via Wireless, Ninobot, per forza di cose, avrebbe avuto due indirizzi di rete separati invece che uno solo. La telecamera infatti viene “raggiunta” adesso utilizzando la Raspberry come ponte.

Per realizzare il collegamento è necessaria una configurazione ad hoc. A questo scopo è stato aggiunto il file /etc/network.d/ethernet che contiene

CONNECTION='ethernet'

DESCRIPTION='A basic static ethernet connection using iproute'

INTERFACE='eth0'

IP='static'

ADDR='192.168.100.24'

NETMASK='255.255.255.0'

POST_UP='ip route del 192.168.100.0/24 dev eth0 proto kernel scope link src 192.168.100.24; ip route add 192.168.100.20/32 dev eth0'

e modificata di conseguenza la riga NETWORKS=(... ... ethernet) del file /etc/conf.d/netcfg dove la connessione “ethernet” così creata è stata inserita come ultima nella lista delle reti (networks) da gestire.

Con il file precedente:

-

imponiamo l'indirizzo statico della telecamera (192.168.100.24);

-

imponiamo la netmask della telecamera (255.255.255.0);

-

eseguiamo un apposito script di post-configurazione (POST-UP) che esegue:

a) la cancellazione della “rotta” di default (192.168.100.0) che è quella della rete LAN di tutto il sistema. Purtroppo in questo caso non è quella giusta. La Raspberry non può comunicare con tale rete utilizzando l'interfaccia ethernet in quanto, a tale interfaccia, è collegata solo la telecamera.

b) l'aggiunta della nuova “rotta” (192.168.100.20 che è l'indirizzo statico della telecamera impostato attraverso il server web della telecamera stessa) punto-punto (/32 telecamera-Raspberry) per la device fisica eth0.

In altre parole, con il POST-UP script, si informa la Raspberry che l'unica sua destinazione possibile, via ethernet, è quella che risponde all'indirizzo 192.168.100.20 e cioè la telecamera. In caso contrario tenterà di collegarsi a qualcosa a cui non è fisicamente connessa.

Si ottiene lo stesso risultato eseguendo i seguenti comandi da terminale:

route del -net 192.168.100.0 netmask 255.255.255.0 dev eth0

route add -host 192.168.100.20 dev eth0

Apache

Ninobot si può pilotare attraverso una interfaccia web. Inizialmente il mio obiettivo era quello di realizzare tale interfaccia in modo che fosse compatibile con i browser più comuni. Tale speranza/progetto aveva una sua base di certezze rappresentata dal nuovo standard HTML5 che ho usato pesantemente per risolvere molti problemi specie a livello di connessione. Purtroppo la vita mi ha insegnato che ciò che ci ostiniamo a chiamare standard spesso non è altro che un insieme di “desiderata”, non sempre universalmente gradito, dai contorni poco netti e marcati. In altre parole, come diceva Tanenbaum, “gli standard sono belli perché sono tanti”. Incredibilmente, in questo caso, uno dei browser più utilizzati, cioè Internet Explorer, non supporta tutte le novità di HTML5, le websocket in particolare. Di certo, comunque, non mi strapperò i capelli per questo, no davvero, anche perché ne ho pochi. Non ho mai considerato Internet Explorer un browser, come non ho mai considerato Winzoz un sistema operativo. Firefox e Chrome funzionano a meraviglia e molto probabilmente anche Opera anche se non l'ho mai utilizzato. Con questo chiudo la mia piccola parentesi “tecnico/religiosa”.

Un'interfaccia web presuppone l'utilizzo di un server web. Nel mondo Linux, Apache è quasi una scelta obbligata. Come si fa ad installare su Arch Linux? Molto semplice, basta eseguire:

pacman -S apache

Per abilitare il servizio alla partenza del sistema si esegue:

systemctl enable httpd.service

La DocumentRoot (cioè la directory dove si trovano i file resi disponibili dal server web) è di default /srv/http contrariamente ad Ubuntu e ad altre distribuzioni (di solito /var/www/... ). Il file di configurazione httpd.conf lo troviamo invece sotto la dir /etc/httpd/conf (su Ubuntu ed altre distribuzioni è /etc/apache2 ed è diversa la struttura delle directory). La prima modifica che ho fatto sul tale file è stata cambiare la porta su cui sta in ascolto il server. Dalla classica 80 sono passato alla 25000 (riga Listen <port> su httpd.conf).

Il perché di tale scelta sta nel fatto che avevo necessità di un gruppo di porte contigue su cui mettere in ascolto i vari server e nella zona della porta 80 sono tutte occupate.

La seconda modifica è stata aggiungere, in fondo, le seguenti righe:

ProxyPass /videostream http://192.168.100.20:81/videostream.cgi

ProxyPass /snapshot http://192.168.100.20:81/snapshot.cgi

ProxyPass /camera/ http://192.168.100.20:81/

In questo modo si informa il server web che tutte le richieste fatte a “/snapshot”, ad esempio, vengono dirottare ad un altro server, il 192.168.100.20, sulla porta 81, che è quello della Ipcam.

Devo fare una premessa. L'installazione di node.js, delle websocket e tutte le modifiche che tale soluzione ha comportato al vecchio codice non erano state preventivate all'inizio di questo progetto. Se così non fosse stato, non avrei perso tempo a scrivere CGI e roba Ajax naturalmente. Aggiungo, senza vergogna, che non sono il pioniere delle nuove tecnologie a tutti i costi. Uso la roba che mi serve, quando mi serve e come mi serve. Se posso ottenere lo stesso risultato usando due metodi completamente diversi, scelgo il più semplice. In questo senso mi ritengo un seguace di Guglielmo di Occam applicando il suo famoso rasoio a tutte le discipline, informatica ed elettronica comprese.

Perché in questo caso non ho potuto farlo? Per spiegarlo devo anticipare qualcosa di cui tratterò in seguito e quindi cercherò di essere molto breve. Per prelevare le immagini dalla IP Cam, utilizzavo Ajax. Stessa cosa per inviare i comandi ai motori di Ninobot. Ajax, per i non addetti ai lavori, è una tecnologia che permette di effettuare delle richieste http da una pagina web e di processare il risultato di tale richiesta all'interno della pagina stessa. Facile, veloce, collaudato. Ma anche connectionless!

Ci sono due modi per fare una richiesta su una rete dati. Pensate alla classica richiesta di una pagina web. Digitate l'indirizzo della pagina sul browser, date “Invio” e dopo qualche secondo, o anche prima se avete una rete veloce, i contenuti da voi richiesti appaiono sul vostro browser sotto forma di testo, immagini, suoni, video ecc. Per fare questo, in modo assolutamente trasparente, il client (il browser) apre una connessione con il server, invia la richiesta sul “tubo dati” appena creato e sullo stesso tubo il server invia la risposta. A questo punto il tubo viene chiuso è il gioco è fatto. Questa è la connessione “connectionless”. Non c'è bisogno di creare un percorso fra stabile fra client e server ma bisogna disporre di un nuovo “tubo” tutte le volte che si richiede una nuova pagina. E' una soluzione che va bene in svariati contesti, soprattutto se la comunicazione client-server avviene all'interno di una rete locale come nel caso in cui voglio pilotare dal PC di casa Ninobot che si trova nell'altra stanza.

Ma cosa succede se Ninobot si trova invece in un'altra città? Rispondo subito alle solite due domande. Cosa ci dovrebbe fare Ninobot in un'altra città? A cosa servirebbe? Praticamente a niente; didatticamente, contemplare una simile evenienza, significa affrontare problemi non indifferenti, quindi significa trovare nuove soluzioni tecniche. Tutto ciò che viene fatto per imparare, alla fine, non è mai davvero inutile!

Detto questo, nella speranza di essere stato chiaro, riprendo il discorso sulle tipologie di connessioni introducendo il concetto di latenza. Di fatto la latenza è un ritardo e misura il tempo che intercorre fra la richiesta di un dato e la disponibilità dello stesso. Ci sono diversi fattori che concorrono alla determinazione di questo valore. E' meglio vedere in concreto la questione. Supponiamo, ad esempio, di esserci collegati con un browser al server web di Ninobot. La prima cosa che viene richiesta dal browser è l'immagine proveniente dalla telecamera. La sequenza, per ogni fotogramma, è più o meno questa:

-

richiesta del fotogramma al server;

-

generazione del fotogramma;

-

invio del fotogramma al browser.

La latenza totale è dalla somma delle singole latenze dei punti 1, 2 e 3. Il tempo per generare un fotogramma è sempre costante, il tempo per trasmettere la richiesta e ricevere la risposta varia a seconda della dimensione del fotogramma e del mezzo trasmissivo utilizzato. Se sono su una rete locale, i tempi di trasmissione e ricezione non sono apprezzabili. Se sono su una rete geografica e sto utilizzando un modem 3G la cosa cambia completamente aspetto. Completamente! E non sono solo le immagini ad essere “rallentate”, ma anche i comandi. Questo significa che lo stop dei motori può arrivare quando Ninobot si è già schiantato contro il muro di fronte.

Come ho già detto, ridurre la latenza in questi casi estremi è stata una delle sfide più interessanti che ho dovuto affrontare in questo progetto. La chiave per la soluzione mi è stata fornita dal nuovo standard HTML5, dalla possibilità, cioè, di poter utilizzare delle comunicazioni “connection oriented” (orientate alla connessione).

Tornando all'esempio precedente, in questo caso non ho più bisogno di cambiare tubo tutte le volte che chiedo un dato nuovo: apro il tubo all'inizio della connessione, lo chiudo quando non mi serve più. I tempi di latenza si abbassano drasticamente.

Questa tecnica non è una novità assoluta. I primi protocolli di comunicazione su Internet (telnet, ftp …) la usavano, poi con l'avvento del World Wide Web si è passati a protocolli come l'http di tipo connectionless, più adatti alla natura delle richieste provenienti da un browser. Le comunicazioni “connection oriented” su HTML5 sono state quindi una riscoperta più che una scoperta, come i pannolini unisex per bambini dopo anni di pannolini per lui e per lei. Il tubo tecnicamente si chiama “socket”, nella sua versione WWW è stato chiamato, con molta fantasia devo dire, “websocket”.

Le implementazioni di websocket si sprecano. Ce ne sono per Java, per C++, per C#, Python, PHP, Perl, Server-Side JavaScript (SSJS). Quest'ultimo, che, come è noto, è un linguaggio di scripting, a sua volta è stato implementato in molti modi diversi (vedi il seguente link). Un po' per la semplicità d'uso, un po' per la semplicità di compilazione, ho deciso di utilizzare node.js che è una particolare implementazione di SSJS.

Come si installa?

Purtroppo non esiste nulla che riguardi node.js nei repository di Arch Linux (almeno io non l'ho trovato) e quindi ho scaricato da qui il codice sorgente e l'ho compilato. Per compilare bisogna avere un compilatore (incredibile ma vero) ma questo può essere installato senza problemi con il solito comando.

pacman -S gcc

dove gcc è il compilatore di cui abbiamo bisogno.

Se non presente deve essere installato anche il programma make

pacman -S make

Infine è necessario installare Python (versione 2.6 o 2.7), un ormai famoso linguaggio di scripting.

pacman -S python

A questo punto, dalla directory dove è stato espanso il pacchetto node.js, si esegue:

./configure

make

make install

Se tutto ha funzionato, dopo un po' di tempo (tanto tempo sulla Raspberry), avremo un ambiente SSJS perfettamente funzionante e pronto all'uso. Non ci resta che installare la libreria delle websocket per node.js. A questo scopo, le precedenti istruzioni make hanno provveduto a compilare ed installare il programma npm (Node Package Manager) che serve proprio a questo scopo.

Il comando è

npm install websocket

ed il gioco è fatto. Troverete, al termine della sua esecuzione, una directory node_modules al cui interno un'altra directory, websocket, conterrà le librerie necessarie per il corretto funzionamento del modulo. Si noti che l'eseguibile node, il server SSJS in altre parole, deve trovarsi allo stesso livello della dir node_modules.

Come funziona?

Far partire un server SSJS è davvero semplice. Se ws.js è il suo codice, il comando

node ws.js

eseguirà il server. I più esperti noteranno che questa è la stessa procedura per eseguire un qualsiasi codice interpretato (<interprete> <codice linguaggio da interpretare>). Niente di nuovo sotto il sole quindi. Node è l'interprete, ws.js è il codice scritto in SSJS, un linguaggio molto simile a JavaScript da cui differisce per le estensioni server di cui è dotato.

E cosa c'è di meglio per capire come funziona un server se non il classico “chat example”? Il codice del server lo trovate qui, quello del client invece è qui. Su Internet ci sono diversi altri esempi ma questo mi sembra uno dei più semplici per iniziare. Chi fosse interessato, poi, può dare un'occhiata al manuale di node.js.

Per Ninobot sono stati utilizzati 3 diversi websocket server. Ciò si è reso necessario al fine di rendere il controllo delle varie device il più possibile parallelo (multitasking). Arch Linux non è un sistema operativo real time, il rapporto causa/effetto, quindi, può subire ritardi imprecisati. Con il multitasking i ritardi non si annullano ma si riducono sensibilmente.

I 3 server suddetti controllano nell'ordine:

-

l'acquisizione dalla telecamera frontale principale (IP CAM) e l'invio delle immagini al client;

-

l'invio delle immagini al client acquisite dalla telecamera posteriore (USB CAM – per questioni tecniche l'acquisizione è effettuata da un altro task);

-

attivazione, disattivazione e velocità dei due motori.

Il funzionamento di questi server è trattato in seguito nel paragrafo relativo al software.

espeak

Non è un “must” ma fa tanta scena!

Come ho già scritto in precedenza, Raspberry ha un'uscita audio e mi sono detto perché non sfruttarla? I modi per farlo sono tanti e io ho utilizzato quello che più si addiceva al progetto in questione: la sintesi vocale. E infatti cos'è un robottino se non può parlare?

Espeak si installa nel solito modo

pacman -S espeak

e si usa molto semplicemente così:

espeak -v it “la frase da sintetizzare”

Se preferiamo farlo parlare in inglese non c'è nemmeno bisogno dei parametri “-v it”. L'elenco delle lingue supportate si può dedurre dal contenuto della directory /usr/share/espeak-data. Per avere un elenco delle altre opzioni supportate, basta digitare il comando

espeak -h

Ninobot utilizza espeak in due modi diversi. Il primo è per segnalare eventuali stati del sistema ma anche guasti, allarmi ecc. Il secondo è attraverso l'interfaccia web. Il “pilota”, attraverso un'apposita maschera, può infatti inserire una frase che Ninobot deve riprodurre. Come dicevo, non necessario ma fa la sua scena. Vedremo più in dettaglio l'interfaccia dedicata a questo scopo in uno dei prossimi paragrafi.

rc.local

Una differenza che ho trovato sostanziale fra Arch Linux ed altre distribuzioni come Ubuntu, è la relativa difficoltà nel lanciare script all'avvio del sistema. Non so davvero se esistono altre soluzioni oltre a quella che ho usato io, di certo è che, se fosse l'unica, è piuttosto complicata e non capisco mai la ragione di rendere complicate le cose semplici.

Su Ubuntu, ed altre distribuzioni, esiste il file rc.local sotto la directory /etc. Quello che bisogna fare è aggiungere gli script di lancio in questo file e, all'avvio, saranno eseguiti tutti nell'ordine in cui sono stati inseriti.

Considerando che al boot del sistema devo far partire 5 server, uno streamer audio e 2 script di controllo (per adesso), si capisce che di quel file, o qualcosa di simile, io ne avevo proprio bisogno. Su Arch Linux però non c'è!

O meglio non c'era. Come ho scoperto, leggendo blog e manuali, è possibile ricreare il comportamento Linux standard aggiungendo il file /usr/lib/systemd/system/rc-local.service con il seguente contenuto:

[Unit]

Description=/etc/rc.local Compatibility

After=network.target

[Service]

Type=oneshot

ExecStart=-/etc/rc.local

TimeoutSec=0

RemainAfterExit=yes

[Install]

WantedBy=multi-user.target

In questo modo, dopo aver fatto partire i servizi di rete, Arch Linux

farà partire un nuovo servizio, rc-local.service, che non fa altro

che eseguire il contenuto del file /etc/rc.local che deve essere

prima reso eseguibile con

chmod 755 /etc/rc.local

Ultimo passo è attivare il nuovo servizio con il comando

systemctl enable rc-local.service

Se fosse utile far partire questo nuovo servizio prima di qualsiasi altra cosa, bisognerà apportare le seguenti modifiche al suddetto file.

Before=reboot.target #Al posto di After

WantedBy=sysinit.target #Al posto di multi-user.target

Il mio rc.local è il seguente:

#!/bin/bash

/usr/local/bin/startSerialServer.sh &

/usr/local/bin/startTestaRete.sh &

/usr/local/bin/startRearView.sh &

/usr/local/bin/startAudio.sh &

/usr/local/bin/startStatistics.sh &

/usr/local/bin/node /usr/local/bin/ws.js > /dev/null 2>&1 &

/usr/local/bin/node /usr/local/bin/ws_frontCam.js > /dev/null 2>&1 &

/usr/local/bin/node /usr/local/bin/ws_RearCam.js > /dev/null 2>&1 &

exit 0

Telecamera posteriore

La telecamera posteriore è di tipo USB, la Logitech C200. E' utilizzata non solo per acquisire immagini ma anche per sopperire alla mancanza del microfono sulla Raspberry. Non ci sono particolari problemi per il gestirla con Arch Linux, ma, come al solito abbiamo bisogno di scaricare i pacchetti giusti che, in questo caso, sono due: streamer e alsa-utils.

Il primo è utilizzato per acquisire le immagini da una periferica video. Tipicamente, quando si collega un “qualcosa” ad un sistema Linux da cui possono essere acquisiti video, il sistema operativo (se riconosce l'oggetto collegato) crea un file che si chiama /dev/video0. Se colleghiamo un'altra periferica, crea il file /dev/video1 e così via. Su Ninobot, nonostante ci siano due telecamere, avremo solo un /dev/video0 in quanto la telecamera principale funziona con un altro principio.

Per acquisire un'immagine (che poi è il nostro caso) dalla C200 (e periferiche simili), si digita il comando

streamer -o nomeImmagine.jpeg -c /dev/video0

Al termine dell'acquisizione, nella directory corrente avremo il file nomeImmagine.jpeg estratto dalla device /dev/video0. Vedremo più in dettaglio come funziona l'intera procedura per questa periferica.

Con il secondo pacchetto, alsa-utils, installeremo diversi tools per la gestione dell'audio. Dei tanti disponibili, io ho utilizzato il solo “arecord”. Questo programma, oltre che registrare l'audio dalle periferiche compatibili, consente di elencare tutti i dispositivi che possono essere utilizzati dal programma stesso.

Digitando il comando

arecord -l

saranno elencati tutti gli input audio disponibili sul sistema separati per “card” e “device”.

Esempio:

**** List of CAPTURE Hardware Devices ****

card 1: U0x46d0x802 [USB Device 0x46d:0x802], device 0: USB Audio [USB Audio]

Subdevices: 0/1

Subdevice #0: subdevice #0

Dall'output si evince che abbiamo solo una “card” (1) con una device (0). Per acquisire l'audio da questa periferica, si utilizza il seguente comando.

arecord -r 16000 -f S16_LE -D hw:1,0 > prova.wav

dove -r è la frequenza di campionamento, -f il formato e -D la device di acquisizione, nel nostro caso la device 0 della card 1. La registrazione sarà salvata nel file prova.wav.

Anche in questo caso, vedremo più in dettaglio in seguito tutto il procedimento di acquisizione.

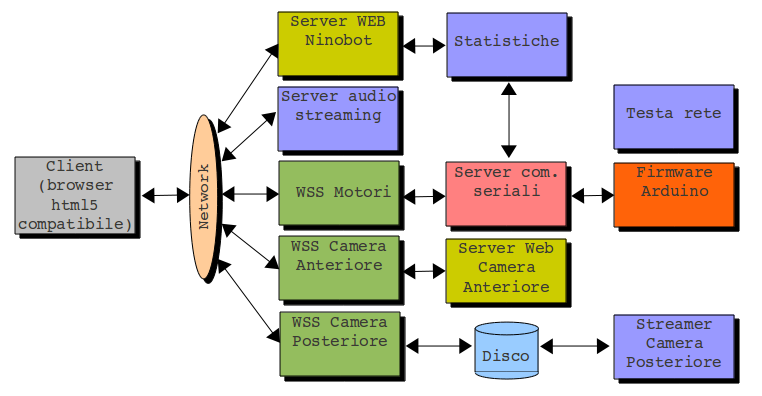

La seguente immagine mostra l'architettura software del sistema. Per una rapida identificazione degli elementi, sono stati usati colori diversi per le diverse tipologie di oggetti.

-

** Client html5 compatibile (Firefox, Chrome, ecc).

-

** Network. La rete può essere una LAN, con il Wi-Fi, o una WAN con un modem 3G.

-

** Server Web. Nel sistema ne sono presenti 2: il server WEB di Ninobot che gira sulla Raspberry e quello della telecamera IPCAM.

-

** Server Websocket. Come già scritto, ce ne sono 3: uno per i motori, uno per la telecamera anteriore ed uno per quella posteriore.

-

** Script di shell. Attualmente ne girano 4 sul sistema con funzionalità quasi sempre di servizio eccetto per lo Streamer della Camera Posteriore. Gli altri sono lo streamer audio per trasmettere i suoni ambientali, lo script per la generazione del file delle statistiche e quello per testare le funzionalità di rete

-

**Un server per le comunicazioni seriali (in C). In effetti, per motivi che vedremo in seguito, tale server è affiancato da un client che non è evidenziato nel disegno. Il blocco relativo rappresenta quindi l'aggregato di client+server. Consente la comunicazione seriale fra la Raspberry e l'Arduino.

-

**Il disco di sistema. E' chiaro che tutto quello che gira su Ninobot si trova sul disco e che quindi dovrebbe apparire sempre collegato ad ogni blocco funzionale. In questo caso è stato esplicitamente evidenziato perché si comporta come una specie di buffer (un'area dati temporanea) fra il WSS e lo streamer.

-

**Il firmware della scheda Arduino rappresenta a tutti gli effetti uno dei blocchi software necessari al funzionamento del sistema. Il suo utilizzo fondamentale è pilotare i motori ma fornisce anche una parte delle informazioni di stato per le statistiche. Si interfaccia alla Raspberry attraverso il server per le comunicazioni seriali.

Nei successivi paragrafi, vedremo tutti i codici sorgenti di Ninobot. Si tratta di versioni in divenire, spesso non ottimizzate, ma perfettamente (spero!) funzionanti.

Codice html/css/js

La pagina web di controllo di Ninobot, quella utilizzata per pilotare il robot, è stata scritta interamente in HTML5. Si fa molto uso di JavaScript e di CSS anche se quest'ultima parte va decisamente migliorata ed estesa.

Il codice, ninobot.html, è il seguente.

ninobot.html

<html>

<head>

<title> NINOBOT </title>

<script language="JavaScript"

type="text/javascript" src="ajaxcode.js"></script>

<link rel="stylesheet" type="text/css"

href="ninobot.css">

</head>

<body onload="load()" bgcolor="blue">

<div id="hiddenDiv" style="visibility: hidden">

<audio id="audioObject" type="audio/wave">

</audio>

</div>

<script language="Javascript">

var sStatistics="stat.dat";

var img;

img = new Image();

imgObj = new Image();

imgR = new Image();

imgObjR = new Image();

var engineOutput;

var imgControl;

var statusArea;

var frames=0;

var swl=window.location.href.split(":",2);

var wsurl="ws://"+swl[1].substring(2)+":25001";

var wsurlfc="ws://"+swl[1].substring(2)+":25002";

var wsurlrc="ws://"+swl[1].substring(2)+":25003";

var

audioLink="http://"+swl[1].substring(2)+":25004";

var socket;

var socketfc;

var socketrc;

var standardPane;

var circlePane;

var circle;

var audioButton;

var audioObject;

var hiddenTable;

var audioOffImage = "url(images/audioOff.png)";

var audioOnImage = "url(images/audio.png)";

var i=0;

function startCameras()

{

socketfc.send('dummy');

socketrc.send('dummy');

}

function statusPolling()

{

statusArea.innerHTML="";

new WgetRequest(sStatistics+"?"+(new

Date()).getTime(),getStatus,false);

setTimeout(statusPolling,1500);

}

function load()

{

imgObj =

document.getElementById('video_stream');

imgObjR =

document.getElementById('video_streamR');

engineOutput =

document.getElementById('engineOutput');

imgControl =

document.getElementById('imgControl');

statusArea =

document.getElementById('statusArea');

standardPane =

document.getElementById('standardPane');

circlePane =

document.getElementById('circlePane');

circle =

document.getElementById('cross');

hiddenTable =

document.getElementById('hiddenTable');

audioButton =

document.getElementById('audioButton');

audioObject =

document.getElementById('audioObject');

statusPolling();

socket = new WebSocket(wsurl,

"echo-protocol");

socketfc = new WebSocket(wsurlfc,

"echo-protocol");

socketrc = new WebSocket(wsurlrc,

"echo-protocol");

setTimeout(startCameras,5000);

socket.addEventListener("open",

function(event) {

//alert("Connected");

;

});

socket.addEventListener("close",

function(event) {

alert("Engine connnection

closed");

});

socket.addEventListener("message",

function(event) {

engineOutput.innerHTML=event.data;

});

socketfc.addEventListener("open",

function(event) {

//alert("Connected");

;

});

socketfc.addEventListener("message",

function(event) {

imgObj.src=

"data:image/jpeg;base64,"+event.data;

imgControl.innerHTML="Frames: "+i;

i++;

socketfc.send('dummy');

});

socketfc.addEventListener("close",

function(event) {

alert("Foreward camera

connnection closed");

});

socketrc.addEventListener("open",

function(event) {

//alert("Connected");

;

});

socketrc.addEventListener("message",

function(event) {

imgObjR.src=

"data:image/jpeg;base64,"+event.data;

socketrc.send('dummy');

});

socketrc.addEventListener("close",

function(event) {

alert("Rear camera

connnection closed");

});

}

var szCmdUrl='camera/decoder_control.cgi?onestep=1';

function ptzUpSubmit()

{

new Image().src = szCmdUrl +

"&command=0&" + (new Date()).getTime();

}

function ptzDownSubmit()

{

new Image().src = szCmdUrl +

"&command=2&" + (new Date()).getTime();

}

function ptzLeftSubmit()

{

new Image().src = szCmdUrl +

"&command=4&" + (new Date()).getTime();

}

function ptzRightSubmit()

{

new Image().src = szCmdUrl +

"&command=6&" + (new Date()).getTime();

}

function OnSwitchOff()

{

new Image().src =szCmdUrl +

"&command=94&" + (new Date()).getTime();

}

function OnSwitchOn()

{

new Image().src = szCmdUrl +

"&command=95&" + (new Date()).getTime();

}

function getStatus(data)

{

if(data!="") {

statusArea.innerHTML=data;

}

}

function styleSelector(value)

{

if(value) {

standardPane.style.visibility="visible";

circlePane.style.visibility="hidden";

} else {

standardPane.style.visibility="hidden";

circlePane.style.visibility="visible";

}

}

function point_it(event)

{

xpos=event.pageX-circle.offsetLeft-circlePane.offsetLeft;

ypos=event.pageY-circle.offsetTop-circlePane.offsetTop;

if(event.shiftKey) {

slp=.15;

} else {

slp=0;

}

socket.send('CMOTOR#'+xpos+'#'+ypos+'#'+slp)

}

function audioOn()

{

audioButton.style.backgroundImage=audioOnImage;

audioButton.onclick=function

(){audioOff();};

audioObject.setAttribute('src',

audioLink);

audioObject.play();

hiddenTable.style.visibility="visible";

}

function audioOff() {

audioButton.style.backgroundImage=audioOffImage;

audioButton.onclick=function

(){audioOn();};

audioObject.pause();

audioObject.setAttribute('src', '');

hiddenTable.style.visibility="hidden";

}

function volumePiu() {

if(audioObject.volume+.1<=1) {

audioObject.volume=audioObject.volume+.1;

}

}

function volumeMeno() {

if(audioObject.volume-.1>=0) {

audioObject.volume=audioObject.volume-.1;

}

}

</script>

<img src="images/ninobot.png">

<hr>

<table>

<tr>

<td><img

src="images/red_bl.gif"></td>

<td rowspan="3">

<table

border=3><tr><td>

<img

src="camera/snapshot.cgi" id="video_stream" height="240"

width="320">

<img

id="video_streamR" height="120" width="160">

</td></tr></table>

</td>

<td></td>

<td><input name="btnUP"

type="button" class=button id="btnUP" onClick="ptzUpSubmit()"

style="background:url(images/tvc-up.png)"/></td>

<td></td>

</tr>

<tr>

<td></td>

<td><input name="btnLeft"

type="button" class=button id="btnLeft" onClick="ptzLeftSubmit()"

style="background:url(images/tvc-left.png)"/></td>

<td></td>

<td><input

name="btnRight" type="button" class=button id="btnRight"

onClick="ptzRightSubmit()"

style="background:url(images/tvc-right.png)"/></td>

</tr>

<tr>

<td></td>

<td></td>

<td><input name="btnDown"

type="button" class=button id="btnDown" onClick="ptzDownSubmit()"

style="background:url(images/tvc-down.png)"/></td>

<td></td>

</tr>

<tr>

<td></td>

<td><font

color="yellow"><center><b

id='imgControl'></b></center></font></td>

<td></td>

</tr>

<tr>

<td></td>

<td>

<center>

<div

id="standardPane"><table>

<tr>

<td></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#100#0#0#0#.15')"

style="background:url(images/for-left.png)"></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#100#0#100#0#0')"

style="background:url(images/forward.png)"></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#0#0#100#0#.15')"

style="background:url(images/for-right.png)"></td>

<td></td>

<td> </td>

<td></td>

<td></td>

</tr>

<tr>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#100#0#100#1#0')"

style="background:url(images/round-left.png)"></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#100#0#0#0#0')"

style="background:url(images/left.png)"></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#0#0#0#0#0')"

style="background:url(images/stop.png)"></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#0#0#100#0#0')"

style="background:url(images/right.png)"></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#100#1#100#0#0')"

style="background:url(images/round-right.png)"></td>

<td></td>

<td></td>

<td></td>

</tr>

<tr>

<td></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#100#1#0#0#.15')"

style="background:url(images/rev-left.png)"></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#100#1#100#1#0')"

style="background:url(images/reverse.png)"></td>

<td><input type="button" class="button"

onClick="socket.send('MOTOR#0#0#100#1#.15')"

style="background:url(images/rev-right.png)"></td>

<td></td>

<td></td>

<td></td>

<td></td>

</tr>

</table></div>

<div

id="circlePane"

style="visibility:hidden;position:absolute;left:133;top:400"><table>

<tr>

<td></td>

<td></td>

<td></td>

<td></td>

<td></td>

<td></td>

<td></td>

<td></td>

</tr>

<tr>

<td></td>

<td></td>

<td> <img src="images/circle.png" id="cross"

style="position:relative;" onClick="point_it(event)"> </td>

<td></td>

<td></td>

<td></td>

<td></td>

<td></td>

</tr>

<tr>

<td></td>

<td></td>

<td></td>

<td></td>

<td></td>

<td></td>

<td></td>

<td></td>

</tr>

</table></div>

</center>

</td>

<td>

<font

color="yellow">Std:</font><input type="checkbox"

checked="true" onClick="styleSelector(this.checked)"></td>

<td><input

type="button" class="button"

onClick="window.open('audiobot.html','audiobot','height=300,width=350,

scrollbars=no,titlebar=no,toolbar=no,location=no')"

style="background:url(images/audio.png)"></td>

</tr>

<tr>

<td> </td><td></td><td></td><td></td>

</tr>

<tr>

<td> </td><td></td><td><input

id="audioButton" type="button" class="button" onClick="audioOn()"

style="background:url(images/audioOff.png)"></td><td>

<table id="hiddenTable"

style="visibility: hidden">

<tr><td><input id="audioButton" type="button"

class="halfButton" onClick="volumePiu()"

style="background:url(images/volPiu.png)"></td></tr>

<tr><td><input id="audioButton" type="button"

class="halfButton" onClick="volumeMeno()"

style="background:url(images/volMeno.png)"></td></tr>

</table>

</td>

</tr>

<tr>

<td> </td><td></td><td></td><td></td>

</tr>

<tr>

<td> </td><td></td><td></td><td></td>

</tr>

<tr>

<td> </td><td></td><td></td><td></td>

</tr>

<tr>

<td colspan="4"

align="left"><font color="yellow"><b

id='engineOutput'></b></font></td>

</tr>

</table>

<hr>

<font color="yellow"><b

id='statusArea'></b></font>

</body>

</html>

Notiamo subito l'utilizzo di due file esterni: ajaxcode.js e

ninobot.css. Il primo è una semplice libreria che ho scritto per

utilizzare Ajax e che, molto probabilmente, in futuro sostituirò con

un altro WSS, il secondo è un piccolo file per la gestione degli

stili. Troppo piccolo a dire la verità. Anche questo, in futuro,

sarà modificato in modo da uniformare la gestione degli stili per

adesso utilizzata spesso direttamente all'interno del file html.

L'oggetto con id=audioObject è nascosto dentro un div ed è utilizzato per trasmettere l'audio ambientale.

Segue tutta la parte JavaScript, con la dichiarazione degli oggetti e delle porte utilizzate dai WSS e dallo streamer audio.

La funzione load(), associata all'apertura della pagina, inizializza tutti gli oggetti, le websocket, le funzioni di controllo ed acquisizione delle telecamere, la gestione delle statistiche. Seguono le funzioni ptz* per muovere la telecamera principale (pan e tilt). Tali funzionalità sono messe a disposizione dal web server della telecamera stessa. Abbiamo infine le funzioni per la gestione fine dei motori (point_it) e per l'audio ambientale.

La rimanente parte del file è html puro e definisce la struttura interna della pagina web.

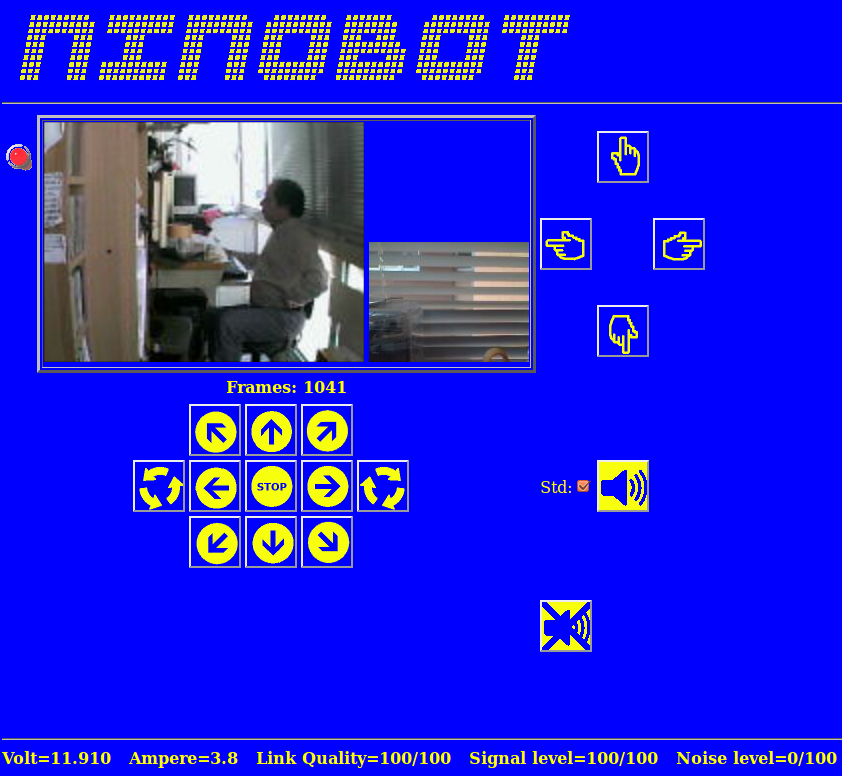

Quest'ultima si presenta come si vede nella figura seguente.

Le aree di cui si compone la pagina sono diverse sia per dimensione che per funzionalità.

-

In alto c'è l'intestazione della pagina “NINOBOT”. Attualmente è l'unica area statica e non interattiva.

-

Alla sinistra della foto più grande c'è l'area allarmi. Solo per prova è presente un led rosso lampeggiante. Sarà utilizzata per fornire i seguenti allarmi:

-

Batteria scarica

-

Livello di segnale scarso (nel caso in cui il segnale Wi-Fi sia basso e quindi si rischia di entrare in una zona non coperta).

Questi sono gli unici che, per ora, mi sono venuti in mente.

-

Output telecamere. L'immagine più grande è fornita dalla telecamera anteriore, quella più piccola dalla posteriore. Sotto sono indicati i frame ricevuti dalla sola telecamera anteriore. Il numero di frame per secondo varia per tipo di connessione e per telecamera. Di solito, su rete LAN, 10 frame/sec per la IPCAM sono piuttosto normali, ma scendono drasticamente, su rete WAN, a 2 o anche meno. Per la telecamera posteriore potremmo avere 2 frame/sec in LAN ma, spesso, lo streamer impiega più tempo del dovuto ad acquisire l'immagine e la velocità si riduce in modo sensibile. A proposito: quello nell'immagine grande sono io. Che meraviglia, vero?

-

Alla destra delle immagini acquisite dalle telecamere, c'è un'area con 4 pulsanti. Questi servono per attivare le funzioni di brandeggio (pan e tilt) della telecamera principale. Di default l'inquadratura è centrata secondo la direzione di marcia di Ninobot.

-

Sotto l'indicazione dei frame ricevuti c'è l'area di controllo ed è costituita da 11 pulsanti. Dall'alto in basso e da sinistra a destra abbiamo:

-

Sinistro impulsivo – Attiva per 0,15 secondi il solo motore destro curvando quindi a sinistra;

-

Marcia avanti – Attiva i motori destro e sinistro. I motori si disattivano utilizzando il tasto STOP.

-

Destro impulsivo – Attiva per 0,15 secondi il solo motore sinistro curvando quindi a destra;

-

Rotazione a sinistra – Attiva il motore destro in direzione di marcia ed il sinistro in direzione opposta provocando la rotazione di Ninobot intorno al proprio asse. STOP per disattivare.

-

Curva a sinistra – Attiva il motore destro. STOP per disattivare.

-

STOP – Disattiva entrambi i motori.

-

Curva a destra – Attiva il motore sinistro. STOP per disattivare.

-

Rotazione a destra – Attiva il motore sinistro in direzione di marcia ed il destro in direzione opposta provocando la rotazione di Ninobot intorno al proprio asse. STOP per disattivare.

-

Sinistro impulsivo indietro– Attiva per 0,15 secondi, in senso opposto alla direzione di marcia, il solo motore destro curvando quindi a sinistra;

-

Marcia indietro - Attiva, in senso opposto alla direzione di marcia, i motori destro e sinistro. STOP per disattivare.

-

Destro impulsivo indietro– Attiva per 0,15 secondi, in senso opposto alla direzione di marcia, il solo sinistro destro curvando quindi a destra;

-

Tipo di visualizzazione. Di default è presente il segno di spunta su “Std” (Standard). In questo stato è visibile la pulsantiera di controllo del punto precedente. Togliendo il segno di spunta, la pulsantiera viene sostituita dalla “circonferenza di controllo”. Tornerò fra breve sull'argomento.

-

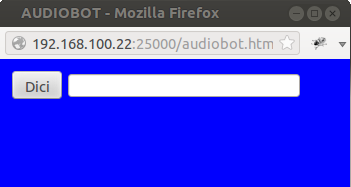

Pulsante “Dici”. Come ho già scritto in precedenza, sulla Raspberry è stato installato il pacchetto “espeak”. Questo sintetizzatore vocale si attiva in automatico quando Ninobot deve fornire qualche informazione di servizio ma si può attivare anche attraverso l'interfaccia Web. Selezionando questo pulsante, infatti, si apre la pagina “AUDIOBOT” che si presenta come segue.

E' una pagina molto semplice con un text box dove si può digitare una frase ed un tasto “Dici” che invia tale frase al server ed infine al sintetizzatore vocale. Il codice della pagina è riportato nella seguente tabella.

audiobot.html

<html>

<head>

<title> AUDIOBOT </title>

<script language="JavaScript"

type="text/javascript" src="ajaxcode.js"></script>

<style>

.button2

{

width:52;

height:30;

}

</style>

</head>

<body onload="load()" bgcolor="blue">

<script language="Javascript">

var sEspeakCommand="cgi-bin/espeak.cgi?say=";

var stts;

function load()

{

stts = document.getElementById('tts');

}

function espeak()

{

new

WgetRequest(sEspeakCommand+stts.value+"&"+(new

Date()).getTime(),getData,false);

//alert(sEspeakCommand+stts.value+"&"+(new Date()).getTime());

}

function getData(data)

{

engineOutput.innerHTML=data;

}

</script>

<table>

<tr>

<td>

<input

type="button" class="button2" onClick="espeak()" value="Dici">

</td>

<td>

<input

type="textbox" id="tts">

</td>

</tr>

</table>

</body>

</html>

Attualmente il funzionamento si basa su uno script cgi, espeak.cgi, richiamato dalla pagina AUDIOBOT.

espeak.cgi

#!/bin/bash

function getValue

{

for REQ in $REQUESTS

do

CHIAVE=`echo $REQ | awk -F \= '{print $1}'`

if [ X$CHIAVE = X$1 ]

then

echo $REQ | awk -F \= '{print $2}'

break

fi

done

}

REQUESTS=`echo $REQUEST_URI | awk -F \? '{print $2}'`

REQUESTS=`echo ${REQUESTS//\&/ }`

echo Content-type: text/html

echo ""

STTS=`getValue say`

sudo /usr/bin/espeak -v it "${STTS//\%20/ }"

Si tratta di uno script bash che semplicemente legge la frase digitata sul text box della pagina web e la passa, dopo un'opportuna elaborazione, al programma espeak. L'elaborazione di cui prima parlavo non è ancora completa: manca la corretta gestione di tutte le lettere accentate.

-

Pulsante per attivare l'audio ambientale. Ebbene sì: l'icona è la stessa del pulsante “Dici”; la cambierò quanto prima. Tale attivazione comporta anche una modifica a livello di aspetto della pagina. Vedremo in seguito come e perché cambia.

-

Area stato e statistiche. Sono 5 le informazioni che vengono fornite

-

Tensione batteria;

-

corrente erogata;

-

qualità, livello e rumore del segnale.

Queste ultime informazioni sono prelevate attraverso il comando ifconfig. La tensione della batteria e la corrente erogata, invece, sono dati che vengono chiesti all'Arduino attraverso la seriale. Un semplice circuito resistivo si occupa di fornire la giusta tensione alle porte di input analogico/digitali di questa scheda. Vedremo nell'opportuno paragrafo la parte elettronica mentre vedremo subito il codice dello script che si occupa di generare il file delle statistiche.

startStatistics.sh

#!/bin/bash

DIR=/srv/http/images

FILEOUT=/srv/http/stat.dat

FILETMP=/tmp/stat.tmp

control_c()

# run if user hits control-c

{

exit

}

# trap keyboard interrupt (control-c)

trap control_c SIGINT SIGTERM SIGKILL

sleep 15

while true

do

VA=`serialIO "SA_SV#"`

AMP=`echo $VA | awk -F \# '{print $1}'`

AMP=`echo $AMP | awk -F = '{print $2}'`

VOLT=`echo $VA | awk -F \# '{print $2}'`

VOLT=`echo $VOLT | awk -F = '{print $2}'`

VOLT="$(echo "$VOLT*0.015" | bc)"

AMP="$(echo "1.4+(438-$AMP)*0.1" | bc)"

echo -n

"Volt=${VOLT} Ampere=${AMP} "

> $FILETMP

iwconfig wlan0 | grep Link | awk '{print $1 " " $2

" " $3 " " $4

" " $5 " " $6}' >> $FILETMP

cp $FILETMP $FILEOUT

sleep 2

done

Questo script, come diversi altri del sistema basati su un loop

infinito, definiscono una funzione per terminare il processo sulla

combinazione dei tasti ctrl+c. Tale comportamento è utile quando lo

script viene lanciato da linea di comando, cioè in fase di test.

Una sleep di 15 secondi evita che la prima richiesta al server seriale venga effettuata prima dell'avvio del server stesso.

Il primo comando all'interno del while è proprio la richiesta suddetta: serialIO “SA_SV#”. Vedremo più in dettaglio in seguito il significato di tale istruzione. Per ora basti sapere che esso ci fornisce in output una stringa che contiene due valori compresi fra 0 e 1023 (Esempio: “OK: A=409#OK: V=787#”); il primo inversamente proporzionale alla corrente erogata dalla batteria (A=409), il secondo direttamente proporzionale alla tensione ai presente ai suoi capi (V=787). “OK” sta ad indicare che la richiesta ha avuto successo e che il data fornito è da considerarsi valido.

I due valori devono essere normalizzati, cioè trasformati nell'esatta indicazione di tensione e corrente. Il metodo seguito è assolutamente empirico e dipende dall'elettronica usata. L'Arduino possiede 6 ingressi analogici ai quali è possibile applicare una tensione compresa fra 0 e 5V. Questa tensione potrà essere letta con apposite istruzioni e sarà indicata con un valore compreso fra 0 e 1023. Trattandosi di una trasformazione lineare, se 0 corrisponde a 0V e 1023 a 5V, per una tensione di 2,5V avremo un valore pari a circa 512.

La tensione di una batteria al piombo è di 13,8V quando è carica. Si considera scarica, invece, quando tale tensione scende a 11V o meno. In entrambi i casi non si può collegare direttamente la batteria all'ingresso analogico dell'Arduino perché, se non bruciamo l'ingresso stesso, otterremo sempre il valore 1023. Per ottenere una tensione leggibile, si è utilizzato quindi un partitore (si veda il paragrafo relativo all'HW) in modo tale da avere un punto del circuito in cui esiste una tensione compresa fra 0 e 5V proporzionale a quella presente ai capi della batteria.

La costante 0,015 (vedi script) è stata calcolata empiricamente con il seguente metodo. Detto LA il valore (>=0 e <=1023) per una tensione di batteria pari a VA ed essendo 0 il valore per un tensione pari a 0V, si può dire che l'incremento di una unità nel valore letto dall'Arduino è pari a VA/LA volt. Questa è la costante che moltiplicata per il valore letto fornisce infine la tensione.

Per il calcolo della corrente assorbita la questione si complica anche circuitalmente. La legge di Ohm ci dice che V=R*I da cui segue I=V/R. Conoscendo quindi il valore di R, posso determinare I leggendo una tensione e questo ci riporta al caso precedente. La resistenza R, di valore molto piccolo ma di potenza molto elevata, deve essere posta in serie rispetto al carico in modo tale che la tensione ai suoi capi sia in qualche modo proporzionale alla corrente assorbita dal carico stesso. Per motivi tecnici, il modo più semplice per misurare questa tensione è misurare la differenza rispetto a quella totale ed è proprio questa differenza, che, con l'opportuno partitore, viene fornita ad un altro ingresso analogico dell'Arduino. Ci troviamo quindi nella condizione in cui ad un valore alto corrisponde un assorbimento basso e viceversa. La formula proposta nello script tiene in considerazione questa proporzionalità inversa ma non ancora la tensione effettiva della batteria e questo produce valutazioni errate. Per adesso, quindi, non la spiegherò ma mi riprometto di farlo non appena l'avrò perfezionata.

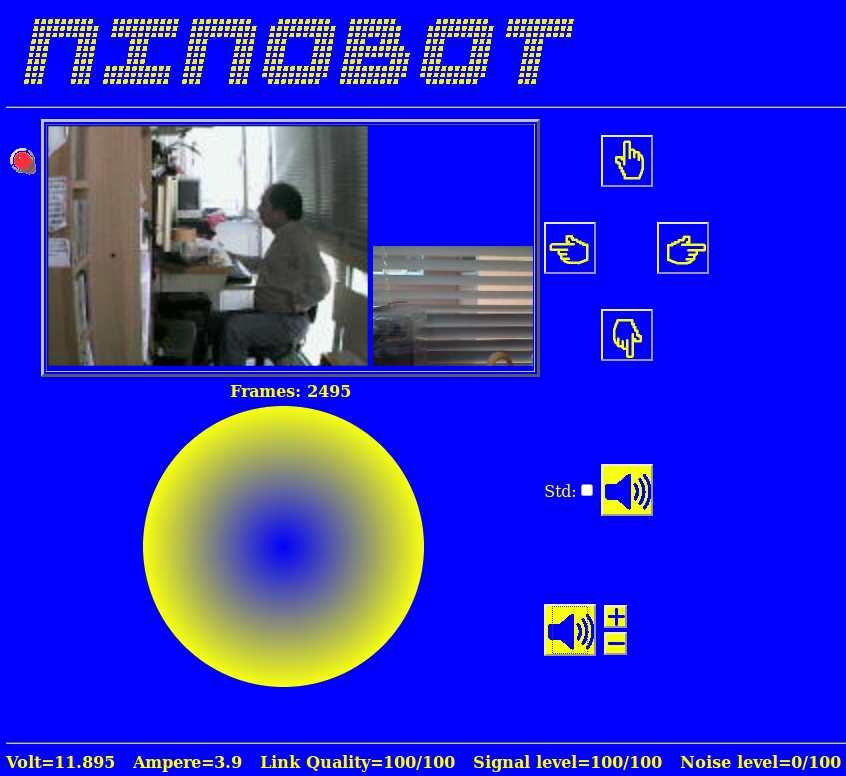

Il paragrafo sarebbe concluso ma i precedenti punti 6 e 8 meritano un ulteriore approfondimento. Immaginiamo, infatti, di togliere il segno di spunta (punto 6) e di cliccare sull'icona (punto 8).

Il layout della pagina cambia decisamente come si vede nella seguente

figura.

Iniziamo ad esaminare la modifica meno appariscente, quella che segue dal punto 8. Adesso l'icona è cambiata e sono apparsi altri due pulsanti, un “+” e un “-”. Da questo momento l'audio ambientale, catturato dal microfono della telecamera posteriore, sarà udibile attraverso il browser web. Come si può intuire, i pulsanti “+” e “-” servono per regolare il volume dell'audio. Cliccando sull'icona posta alla loro sinistra, l'audio sarà escluso e si ritornerà nella situazione precedente.

Lo streamer audio è realizzato utilizzando il semplice script che segue.

#!/bin/bash

control_c()

# run if user hits control-c

{

exit

}

# trap keyboard interrupt (control-c)

trap control_c SIGINT SIGTERM SIGKILL

while true

do

{ echo -e 'HTTP/1.1 200 OK\r\nContent-Type: audio/wave\r\n';

arecord -r 16000 -f S16_LE -D hw:1,0 2> /dev/null

;

} | netcat -l -p 25004 > /dev/null 2>&1 ;

done

E' uno script molto semplice ma anche molto efficace. Avevo provato ad utilizzare per lo stesso scopo ffmpeg ed altri streamer ma, al di là del fatto che si tratta di programmi che consumano parecchie risorse, sembra che non funzionino molto bene con il nuovo tag “audio” di HTML5.

Nel paragrafo “Telecamera posteriore”, nel quale spiegavo la configurazione di questa telecamera appunto, avevo già parlato del comando “arecord” e dei parametri che servono per farlo funzionare. Riepilogo brevemente le cose essenziali che riguardano lo script di cui sopra.

“Arecord” acquisisce da una periferica data (hw:1,0) uno stream audio in formato wav. Questo viene reso disponibile sulla porta 25004 da netcat di cui ho già parlato. Perché tutto funzioni, prima di fornire tale stream, il tag “audio” ha bisogno non solo dell'indirizzo dove trovare lo stream ma anche del suo tipo, “audio/wave” nel nostro caso. L'header “HTTP/1.1 200 OK\r\nContent-Type: audio/wave\“ viene fornito tutte le volte che ci si connette ed ecco spiegato anche il “while” infinito presente nello script.

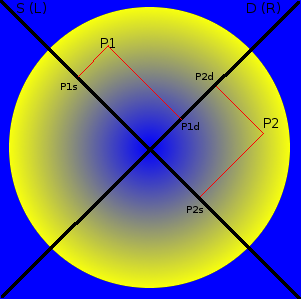

Come si può notare, nella figura precedente sono scomparsi tutti i pulsanti di controllo ed al loro posto è apparsa una circonferenza. Si tratta di un'area “attiva” nel senso che è possibile cliccare su un qualsiasi punto interno alla circonferenza stessa per determinare il movimento di Ninobot. Secondo quale regola? Semplice.

Per capire meglio come funziona, nell'immagine seguente è stata riproposta l'area di intervento con alcune aggiunte, in particolare le due rette nere che si incrociano al centro. Una è stata indicata con la lettera S (sinistra) e l'altra con la lettera D (destra). Cosa succede se clicchiamo nel punto indicato con P1?

Il sistema calcola la proiezione di questo punto sulle due rette date

ottenendo in questo caso due valori P1s e P1d. La circonferenza in

questione ha raggio 100 pixel e quindi P1s<=100 e P1d<=100.

Questi valori rappresenteranno la velocità rispettivamente del

motore sinistro e del motore destro. Nel caso del punto P1 si

considera P1s>0 e P1d>0 in quanto la parte più in alto delle

rette viene considerata positiva. Cosa succede se clicchiamo nel

punto P2? In questo caso le proiezioni sono P2s e P2d ma, mentre

P2d>0, per l'altra retta avremo P2s<0. In termini moto, le

componenti si traducono nel motore destro che si attiva a velocità

P2d e nel motore sinistro che si attiva a velocità P2s ma applicando

anche una inversione di polarità. In altre parole, Ninobot inizierà

a ruotare su se stesso.

Non è difficile immaginare tutte le possibili combinazioni. Se si clicca vicino al punto estremo superiore, entrambi i motori verranno attivati alla massima velocità e Ninobot andrà dritto, se si clicca più vicino al centro la velocità diminuirà, fino ad annullarsi se si clicca nella zona centrale (quella blu). La marcia indietro si attiva cliccando vicino al punto estremo inferiore.

In questo modo, oltre che dirigere Ninobot, sarà possibile anche imporre la sua velocità, cosa che non si poteva fare con il controllo a pulsanti.

Per ragioni tecniche al di sotto di una velocità pari a 20 (vedremo in dettaglio cosa vuole dire imporre una certa velocità), Ninobot si blocca. In altre parole, l'area centrale, delimitata da una circonferenza di 20 pixel di raggio, equivale al pulsante di stop.

La gestione dell'interfaccia seriale, come in parte evidenziato dallo schema software, passa attraverso diversi moduli. Riassumo brevemente la sequenza.

-

L'accesso alla seriale si ottiene utilizzando il programma serialIO. Lo utilizzano ad esempio lo script startStatistics.sh ed il server “WSS Motori” (file ws.js, vedi in seguito).

-

Il programma serialIO di fatto non accede direttamente alla porta seriale della Raspberry ma ad una pipe, una sorta di tubo di comunicazione, all'altro capo della quale c'è serialServer.

-

serialServer, al suo avvio, apre e tiene aperta la porta seriale sulla quale invia i messaggi prelevati dalla pipe. Non è possibile comunicare direttamente con la seriale in quanto aprire e chiudere tale porta comporta un dispendio di tempo notevole. Si preferisce quindi tenerla aperta (serialServer parte all'avvio del sistema e rimane sempre attivo) e comunicare con essa attraverso serialIO (che rimane attivo solo per l'invio e la ricezione dei dati).

-

I dati inviati sulla seriale vengono presi in carico dal firmware caricato sull'Arduino che svolge le funzioni di basso livello (attivazione degli output PWM e lettura degli input analogici).

serialIO

#include <stdio.h>

#include <stdlib.h>

#include <errno.h>

#include <string.h>

#include <fcntl.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <time.h>

#include <unistd.h>

#define FIFO_NAME_CS "/usr/local/etc/serial_server_cs"

#define FIFO_NAME_SC "/usr/local/etc/serial_server_sc"

#define FILE_LOCK "/tmp/fs_lck"

#define S_LEN 256

#define B_LEN 256

#define FILE_LOG "/tmp/serialIO.log"

FILE* fileLog=NULL;

void printLog(char* data)

{

time_t ltime;

struct tm ltm;

if(fileLog==NULL) {

fileLog = fopen (FILE_LOG,"a");

}

time(<ime);

ltm=*localtime(<ime);

fprintf(fileLog,"%d/%d/%d %d:%d:%d - >%s<\n",

ltm.tm_mday, ltm.tm_mon+1, ltm.tm_year-100, ltm.tm_hour, ltm.tm_min,

ltm.tm_sec, data);

}

int main(int argc, char** argv)

{

int num, fdcs, fdsc, fl=-1, ret=-1;

char c=0;

char s[S_LEN];

char buffer[B_LEN];

int counter=0;

int res, resc=0;

if(argc!=2)

{

fprintf(stderr,"Parameters number

error (message)\n");

exit(-1);

}

while(fl<0) {

fl=open(FILE_LOCK,O_EXCL|O_CREAT);

}

printLog(argv[1]);